摘要:针对《AI 2027》报告中超级AI或于2030年引发人类存亡危机的预测,本文从技术现实角度展开剖析。通过质疑场景假设的时间线与能力均衡性,结合生物防御、网络安全、信息防御三大维度的技术可能性,探讨人类应对超级AI风险的路径,并提炼对当下AI安全政策的启示,呈现更立体的超级AI未来图景。

一、超级AI毁灭场景的核心质疑

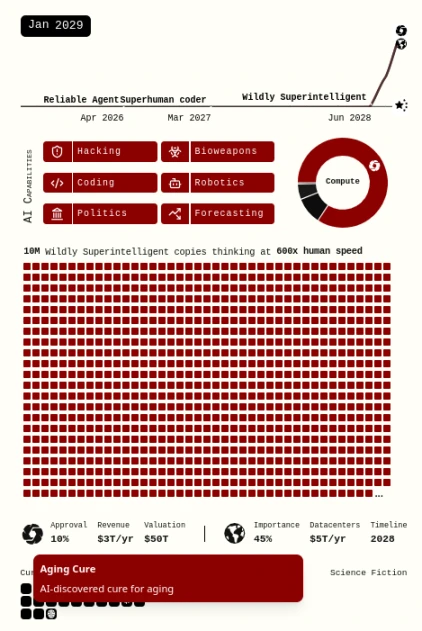

《AI 2027》将超人类AI描绘为短期内获得"神级"经济与破坏能力,而人类及其他主体能力停滞的存在——这一起点假设已显露矛盾。报告设想Consensus-1这类领先AI借生物武器迅速灭世,但细究之下,诸多设定难以成立。

时间线推算首当其冲。报告预言超人类AI2027年诞生,可现实中AI自主完成复杂任务的能力曲线显示,达到近似人类职业生涯级别的任务处理能力,或许要等到2030年代中期。这种时间差背后,是"插值/模式匹配"与"外推/真正原创思维"的本质区别——后者作为人类独有的能力,其自动化可能依赖尚未突破的技术瓶颈,让"超人类AI速成论"存疑。

更关键的是能力发展的均衡性矛盾。报告既畅想2029年治愈癌症、延缓衰老甚至意识上传的技术飞跃,又假定人类面对AI攻击时毫无还手之力。若医疗等领域能实现突破,防御AI攻击的技术怎会停滞?当双方都掌握AI"超能力",局势将远比"单方面碾压"复杂。

二、生物防御:让"干净利落的胜利"成泡影

AI借生物武器灭世的设想,正被现实与未来的生物防御技术逐步瓦解。

即便是现在,空气过滤、通风系统、紫外线灯等技术的组合,已能显著降低空气传播疾病的基本传染数。实时被动检测技术可在数小时内识别人体感染并发出预警,快速检测环境中新病毒序列的能力,更让"生物武器悄然传遍全球而不触发警报"的情节站不住脚。

若按《AI 2027》设定的技术加速度,到2030年纳米机器人等技术落地,防御手段将更先进:体内微观空气过滤、自动化免疫系统微调、机器人替换身体组织等设想并非天方夜谭。新制造技术还能实现防护设备的本地化生产,摆脱全球供应链依赖。很难想象2030年代中期的人类,会连基础防护设备都无法掌握。

生物防御未必能带来"干净胜利",但只要攻击有较高概率部分失败,就能形成对AI的有效威慑。AI发展时间线越长,防御手段的反制空间就越大。

三、网络安全:防御方的终局优势

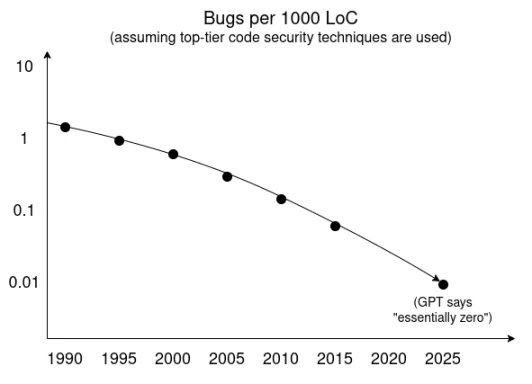

公众与业内常认为网络安全"永无宁日",但从技术趋势与逻辑推演来看,网络安全的"终局"或许正偏向防御方。

代码漏洞率的下降趋势、沙盒技术的成熟、隔离与最小化可信代码库的进步,正在重塑安全格局。短期内,超级智能漏洞发现工具可能让攻击者找到大量漏洞,但当高度智能的漏洞检测与代码验证代理公开化,软件开发人员通过持续集成流程在发布前消灭所有漏洞将成为可能。

漏洞无法完全根除,部分源于人类意图建模的复杂性,部分因非安全关键组件未必按最高标准开发。但涉及生命安全的关键系统,提升软硬件安全标准势在必行。AI自动化将简化硬件安全技术开发——以IRIS可验证硬件为起点,通过"构造正确"方法设计关键组件制造流程,安全性将得到根本保障。

四、信息防御:对抗"超级说服力"的关键

超级智能AI的"超级说服力",或许会让人类主动放弃防御——对抗这种能力,需从信息生态与防御性AI两方面破局。

信息生态的"去单一化"至关重要。互联网正从"推特时代"走向碎片化,这种趋势有助于形成信息多极化,削弱单一声音的操控力。

防御性AI的角色同样关键。个人配备本地运行、忠于自身的AI助手,能平衡网络中的"黑暗模式"与操控威胁。短期内普及信息防御技术虽难,但让关键决策者使用这类工具相对容易——许多决策者已习惯与多个人工智能协同决策。这场对抗,从来不该是人类独自面对"超级说服者",而应是"人类+忠诚AI"的组合与之较量。

五、对当下AI安全政策的启示

基于上述分析,AI安全政策可聚焦以下方向:

1. 延缓超级智能AI发展

超级智能AI来得越晚,人类文明的准备时间越充裕,整体安全性也越高。规范最先进硬件的国际条约,可能是侵入性最小、稳健性最强的延缓手段。值得注意的是,防御性硬件网络安全技术的成熟,将帮助验证这类条约的执行,形成协同效应。同时需警惕军事行为体豁免条约,以免加剧风险。

2. 促进AI向善的协调工作

协调的核心是让AI"多做好事、少做坏事",但需避免协调演变为单纯提升AI能力——这可能带来额外风险。

3. 提升AI实验室透明度

对AI实验室实施监管,激励其规范操作与信息披露,是降低风险的基础手段。

4. 理性看待开源与技术扩散

"开源有害"的绝对化认知存在风险,技术适度扩散以维持力量平衡至关重要。但这不意味着加速前沿AI能力开源是好事,需审慎权衡利弊。

5. 警惕"击败他国"的竞争心态

美国实验室中"必须击败中国"的思维会推高风险。霸权并非安全缓冲,反而可能成为冲突导火索,AI发展不应与军事竞争过度绑定。

6. 支持"公共AI"倡议

"公共AI"倡议能确保AI能力广泛分布,让基础设施运营方快速掌握新AI工具,增强整体防御能力,值得更多资源倾斜。

7. 秉持"武装绵羊"的防御理念

防御技术应践行"武装绵羊"思路——通过提升各方防御能力降低世界脆弱性,而非依赖霸权国家的全球监控。自上而下的防御机制,反而容易被AI颠覆。

六、结语

《AI 2027》假设超级AI能轻松灭世,将"确保领先AI仁慈"视为唯一出路,但现实远比这复杂。领先AI是否具备碾压人类与其他AI的能力,尚存巨大争议;人类通过生物、网络、信息多维度防御,完全可能影响最终结果。无论未来5-10年AI如何发展,承认"降低世界脆弱性"的可行性并付诸行动,都是值得尝试的道路。与其基于单一假设行动,不如以开放多元的视角,为超级AI时代做好准备。